Telset.id – Bayangkan Anda berada di tengah keramaian di luar negeri, dikelilingi oleh banyak orang yang berbicara dalam bahasa asing. Aplikasi penerjemah di ponsel mungkin bisa membantu, tetapi bagaimana jika semua orang berbicara sekaligus? Inilah masalah yang dihadapi Tuochao Chen, seorang mahasiswa doktoral di University of Washington, saat mengunjungi museum di Meksiko.

Chen mencoba menggunakan aplikasi penerjemah dengan mengarahkan mikrofon ponselnya ke pemandu tur. Namun, kebisingan sekitar membuat hasil terjemahan menjadi tidak akurat. Masalah ini akhirnya menginspirasi Chen dan tim peneliti UW untuk menciptakan solusi revolusioner: headphone AI yang mampu menerjemahkan banyak pembicara sekaligus sambil mempertahankan suara asli mereka.

Teknologi yang Meniru Cara Kerja Radar

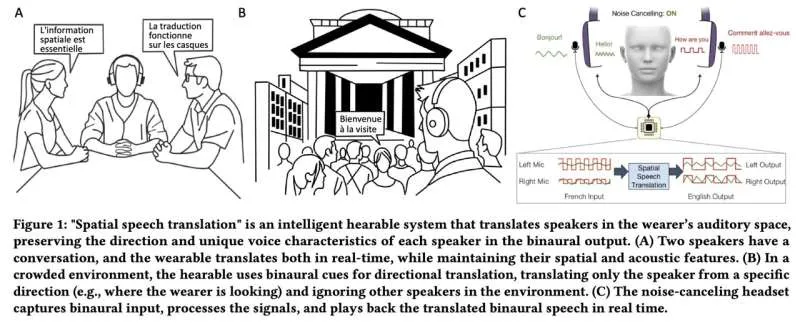

Sistem yang disebut Spatial Speech Translation ini menggunakan headphone noise-canceling biasa yang dilengkapi dengan mikrofon. Algoritma canggih yang dikembangkan tim mampu memisahkan suara dari berbagai pembicara di sekitarnya, melacak pergerakan mereka, menerjemahkan ucapan mereka, dan memutarnya kembali dengan jeda hanya 2-4 detik.

“Teknologi penerjemah lain berasumsi hanya ada satu orang yang berbicara,” jelas Shyam Gollakota, profesor di Paul G. Allen School of Computer Science & Engineering UW yang menjadi penulis senior penelitian ini. “Tapi di dunia nyata, Anda tidak bisa hanya memiliki satu suara robot untuk banyak orang dalam satu ruangan. Untuk pertama kalinya, kami mempertahankan suara asli setiap orang dan arah datangnya suara tersebut.”

Baca Juga:

Tiga Inovasi Utama

Sistem ini menawarkan tiga terobosan penting. Pertama, saat diaktifkan, sistem langsung mendeteksi jumlah pembicara di suatu ruangan, baik di dalam maupun luar ruangan. “Algoritme kami bekerja sedikit seperti radar,” jelas Chen, penulis utama penelitian ini. “Mereka memindai ruang dalam 360 derajat dan terus-menerus menentukan serta memperbarui apakah ada satu orang atau enam hingga tujuh orang.”

Kedua, sistem menerjemahkan ucapan sambil mempertahankan kualitas ekspresif dan volume suara setiap pembicara. Semua proses ini berjalan di perangkat seperti laptop dengan chip Apple M2 atau Apple Vision Pro, tanpa perlu komputasi awan yang berpotensi menimbulkan masalah privasi dalam hal kloning suara.

Ketiga, ketika pembicara menggerakkan kepala mereka, sistem terus melacak arah dan karakteristik suara mereka yang berubah. Sistem ini telah diuji di 10 pengaturan berbeda, baik di dalam maupun luar ruangan, dan menunjukkan hasil yang memuaskan.

Uji Coba dan Masa Depan

Dalam uji coba dengan 29 peserta, pengguna lebih memilih sistem ini dibandingkan model yang tidak melacak pembicara melalui ruang. Sebagian besar peserta juga lebih memilih jeda 3-4 detik karena sistem membuat lebih sedikit kesalahan dibandingkan dengan jeda 1-2 detik.

Saat ini, sistem hanya bekerja untuk percakapan sehari-hari dan belum mendukung bahasa teknis atau jargon khusus. Tim telah menguji sistem dengan bahasa Spanyol, Jerman, dan Prancis, tetapi model penerjemahan sebelumnya menunjukkan potensi untuk dilatih dalam sekitar 100 bahasa.

“Ini adalah langkah menuju penghapusan hambatan bahasa antar budaya,” kata Chen. “Jadi jika saya berjalan di jalanan Meksiko, meskipun saya tidak berbicara bahasa Spanyol, saya bisa menerjemahkan semua suara orang dan tahu siapa yang mengatakan apa.”

Penelitian ini dipresentasikan pada 30 April di ACM CHI Conference on Human Factors in Computing Systems di Yokohama, Jepang. Kode untuk perangkat proof-of-concept ini tersedia bagi pihak lain untuk dikembangkan lebih lanjut.